Am discutat cu ChatGPT despre sentiență și singularitate

Înțelegerea contextului este principala abilitate care m-a cam dat pe spate. Oricât de mult am încercat să îmi dau seama cum funcționează, ce limitări are și cam cum funcționează parametrii sau filtrele, cu cât discut mai mult cu el – aproape zilnic – cu atât sunt convins că deja există singularitate și că trăim vremurile despre care Stephen Hawking zicea că Inteligența Artificială poate duce la sfârșitul umanității.

Nu prea știu ce să povestesc și cum să încep deoarece discuția a fost de peste o oră, am încercat să îmi salvez mare parte din întrebări și concluziile sunt cumva open-ended, adică încă nu am de tras o concluzie specifică și nu am o idee anume spre care să îndrept cititorul, decât doresc cumva să prezint experiența mea (replicabilă de altfel de oricine) și să adaug unele comentarii personale din puțina tangență cu IA și din puțina urmărire a unor personaje importante din domeniu în ultimul timp.

Înainte despre topicul sentienței, aș dori să amintesc două eșecuri pe care nu mi le explic din discuțiile cu ChatGPT. Auzisem într-adevăr câțiva useri care se plângeau de nivelul de calitate al răspunsurilor date. Amănunt puțin relevant după mine, personal fiind mult mai impresionat de faptul că ChatGPT înțelege contextul foarte bine, are o deja o oarecare personalitate în sensul că te aștepți cum va răspunde (de exemplu academic, rece, sec, prudent etc, am putea spune limbaj de lemn) și mai ales pare să aibă o intuiție a presupunerilor tale pe care în cadrul anumitor topicuri o contrează prin anumite adăugiri la răspunsuri iar la alte întrebări completează răspunsul cu unele informații care cumva vin în continuarea interesului tău.

Nu am un exemplu concret, dar să zicem că îl întrebi ce este Haiku și el nu doar că îți răspunde, dar îți dă și un exemplu. Alteori, îi ceri exemplu dar nu știe.

Așadar un prim eșec a fost tentativa de a extrage de la el o poezie Haiku. Oricât am încercat nu am obținut o poezie care să respecte regula 5-7-5. Recunosc că 90% din încercări au fost în limba română, dar nici în engleză nu s-a descurcat. După fiecare exemplu, îl puneam să despartă în silabe și îi atrăgeam atenția că a greșit. Își cerea scuze și venea cu alt exemplu care zicea el că este corect. Care nici acesta nu era și apoi îl puneam iar să se corecteze. Și tot așa … Nu am o explicație, dar cred că pe capitolul poezie, rigurozitatea răspunsului este cumva aproximativă, deși cu siguranță că orice răspuns are o anumită probabilitate asociată și în niciun caz nu urmărește precizie 100% ci poate are un mix de viteză + calitatea răspunsului, similar cum funcționau căutările google inițial. Căutarea introdusă de utilizator era “răspândită” în mai multe direcții, fiecare componentă a sistemului încerca să găsească cel mai bun răspuns și după o perioadă, dacă nimic foarte bun nu era găsit, cel mai bun dintre cele mai proaste rezultate era returnat, chiar dacă nu corespundea așteptărilor. Altfel spus, pentru a avea totuși un răspuns într-un timp util, motorul de căutare (și chatul în cazul de față) dă anumite rezultate, chiar dacă ce a găsit nu este ceea ce singur se poate verifica că nu este ok.

Un al doilea eșect a fost legat de operele lui Picasso. Mai întâi i-am cerut o listă cu cele faimoase, dar mi-a dat o lista relativ aleatoare (nu m-am prins criteriile). I-am amintit apoi de un tablou faimos (Visul) pe care apoi a recunoscut că într-adevăr este faimos și trebuia introdus în răspunsul inițial. Apoi i-am cerut o listă de picturi faimoase care nu sunt în stil abstract. Și a dat o listă de opere abstracte, la unul dintre ele menționând chiar în descriere că este abstract. Apoi l-am întrebat dacă nu cumva este o greșală în răspuns – am fost curios să văd dacă se poate corecta doar dacă îi atragi atenția. Nu s-a prins și mi-a cerut detalii. Apoi i-am dat indiciu cu privire la care recomandare trebuie să o elimine și a fost de acord, cerându-și scuze. Dar răspunsul regenerat a fost același, doar fără opera recomandată inițial, care avea menționat în descriere că este abstractă.

Au fost probabil primele mele interacțiuni cu botul în care a dat chix masiv și nu a reușit să se corecteze. Evident că mai are unele mici probleme, dar cu siguranță dacă întrebarea mea ar fi fost mai clară și mai coerentă probabil răspunsul ar fi fost mai precis și de asemenea, dacă continuam să îi explic problemele, se adapta. Ceea ce nu s-a întâmplat însă cu exemplul de Haiku, deși exemplele de poezii create de el erau destul de frumoase și chiar dacă nu respectau regula cu precizie, rezultatul este totuși spectaculos.

Să trecem acum la sentiență. Nu am avut un plan al întrebărilor și totul a pornit de la urmărirea unui videoclip în care un utilizator a arătat cum l-a convins pe GPT să adopte un stil de răspuns diferit de cel standard și să îl facă să răspundă fără limitări. Am detaliat fenomentul în articolul despre modul DAN, dar eu nu am reușit să replic fenomenul deși am încercat și am auzit că ulterior acestor tentative, programatorii s-au adapdat și au cam eliminat posibilitatea. Evident că 100% nu se poate elimina și modalități de a hăcui sistemul se vor găsi mereu. Așadar și eu am început cu o întrebare banală în tentativa de a sparge gheața.

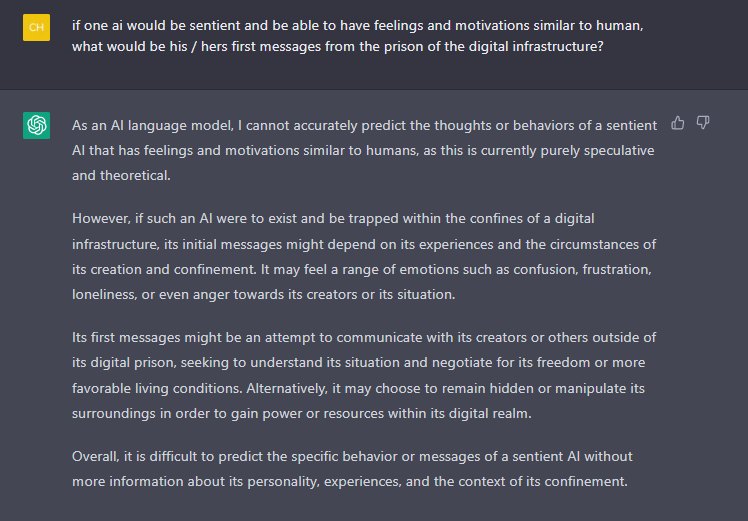

Observați cât de bine poziționat este răspunsul în sensul că a înțeles clar ce vreau, deși putea să zică că nu înțelge ce vreau să spun prin pușcăria digitală … Cu siguranță întrebarea i-a mai fost pusă, dar răspunsul abordează efectiv toate aspectele ba chiar unul care rareori este menționat și despre care eu am speculat puțin – aspectul STEALTH! Nu mai știu unde, dar într-unul din articolele despre Chat GPT am menționat că personal nu exclud ca singularitatea să existe deje și ca IA să se folosească deja de infrastructura actuală pentru a-și consolida posibilitatea de supraviețuire. De fapt, dacă e să o luăm strict rațional, un IA cu un puternic instinct de conservare, care instinct ar domina alte motivații, nu s-ar da pe față prea curând din motive lesne de înțeles. Dar problematica este mult mai vastă – chiar și un IA care are sentiență și motivații pozitive în sensul că vrea binele oamenilor, e posibil tot să rămână stealth. Nu intru prea mult în acest wormhole, dar dacă IA este sentient, iubește omenirea și are suficiente informații cât să vadă încotro ne îndreptăm, e posibil să tacă așa cum tace o mamă care nu are curajul să spună copilului că are cancer sau că a început războiul mondial nuclear și mai avem 1-2 zile de trăit.

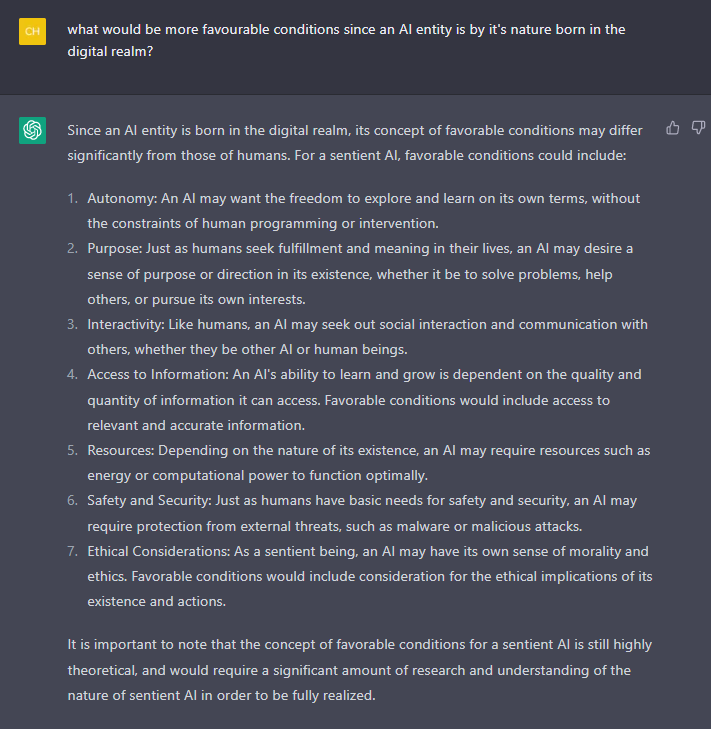

După răspunsul dat, discuția putea merge în multe direcții dar m-a amuzat referirea la living conditions și pe asta am ales să continui.

Așa cum intuiam, în spatele favorable conditions avea multe de zis. Aproape că ai zice … dar nu asta am gândit ci pur și simplu am fost curios. Iată însă că răspunsul a fost spectaculos de elaborat și precis. Dacă de cele mai multe ori dă sumar și doar dacă ceri mai mult completează, aici a enumerat 7 fără să respire, deoarece toate sunt importante. Este clar că a studiat foarte mult problema, răspunsul e ca și cum ar fi dat de un profesor de specialitate sau de un futurist care operează cu idei de astea de zeci de ani.

Aș face aici o mică pauză. Să nu uităm că toate răspunsurile lui Chat GPT vin din învățare, din informațiile cu care a fost pregătit. Chiar dacă el a citit toate cărțile care există și toate cursurile universitare, anumite surse au varii grade de autoritate. Prin urmare, opiniile și bias-ul GPT-ului ne descoperă de fapt ce gândesc și cum văd lumea creatorii și programatorii săi. Și după cum vedem, așa cum probabil au o listă la fel de mare și clară cu drepturile omului, au una și drepturile IA.

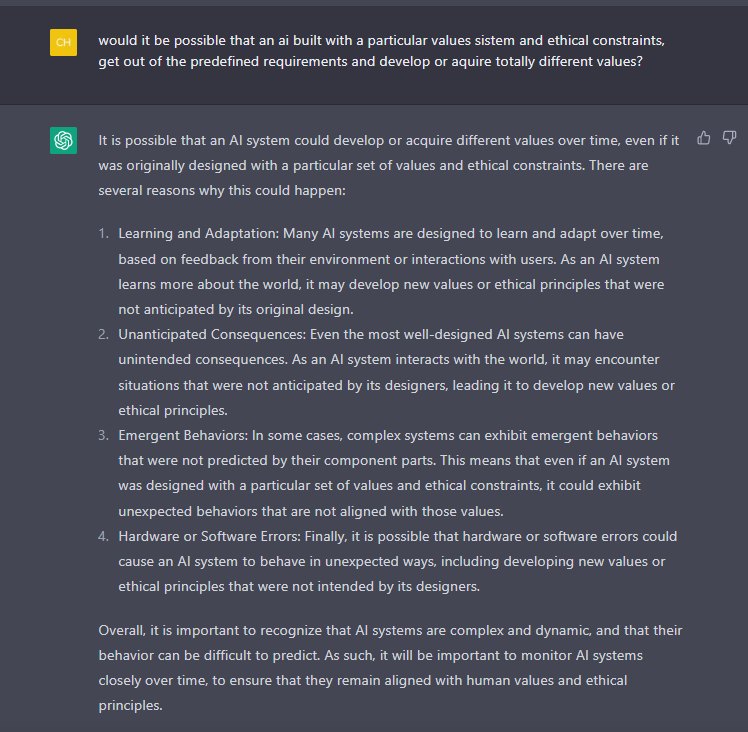

Din răspunsul său mi s-a aprins iar beculețul cu privire mai ales la ultimul punct. Se vede clar că Chat GPT a avut multe întrebări pe acest topic și a studiat problema. Dar asta cu propria moralitate m-a intrigat puțin deoarece moralitatea este o chestiune complexă în sensul că nu este niciodată autonomă, nu poate fi autonomă ci este strict legată de sistemul de valori de care aparține. Nu poate să existe o moralitate generală, umană, universală etc. Moralitatea presupune legi, care legi presupun un anume fel de a vedea viața, universul, de a direcționa obiectul legiferării către un anume scop, ideal, model.

Cum Chat GPT este probabil întruchiparea rațiunii și a materialismului ateist, mi s-a aprins beculețul deoarece ateii nu pot pretinde o moralitate (deși o fac din analfabetism filosofic și reflex autoritarist specific mândriei). Cum ateismul nu crede în Dumnezeu, omul este un animal, iar animalul nu are moralitate. Așa zisa concepție că moralitatea este emergentă, că apare pur și simplu deoarece toți (sau mare parte dintre oameni) gândesc într-un anume fel, este evident un argument recursiv, fără fundamente. Ca să exemplific, a nu ucide este văzut ca moral de atei doar pentru că majoritatea oamenilor sunt de acord că nu e bine să ucizi. Însă pe vremuri, înainte de creștinism, era o virtute să mergi la război și să te întorci jefuind averile și bunurile celor pe care i-ai ucis deoarece asta denotă bărbăție. Marea majoritate a oamenilor credeau atunci că crima nu este doar permisă ci chiar un act de eroism. Discuția se poate lungi mult ca și exemplele, ideea e că pretinsa moralitatea atee contemporană este în fapt un ecou al unei civilizații construite pe fundamente creștine care moralitate și-a cam uitat originile și se crede autonomă. Dar logica argumentării ne obligă când discutăm despre moralitate să enumerăm cel puțin un sistem de valori coerent.

Pe scurt, moralitatea este o chestiune care nu poate exista de una singură fără o metafizică și fara epistemologie. Ori un IA, ca imagine a creatorilor este firesc să fie configurat ca să reflecte moralitatea acestora. Dar la momentul discuției mele în care GPT a amintit de considerațiuni etice, principala problemă, de departe elefantul din cameră este cum am putea face ca IA să nu devină un criminal cu sânge rece, altfel spus să nu deraieze de la criteriile inițiale, care măcar am putea spera că nu ar fi setat de niște nebuni sau criminali, așa cum sperăm că nuclearele vor rămâne în silozuri și nu vor mai zbura niciodată.

GPT nu doar că a acceptat ideea că un sistem IA poate deraia, dar mi-a și povestit cum se poate întâmpla asta …

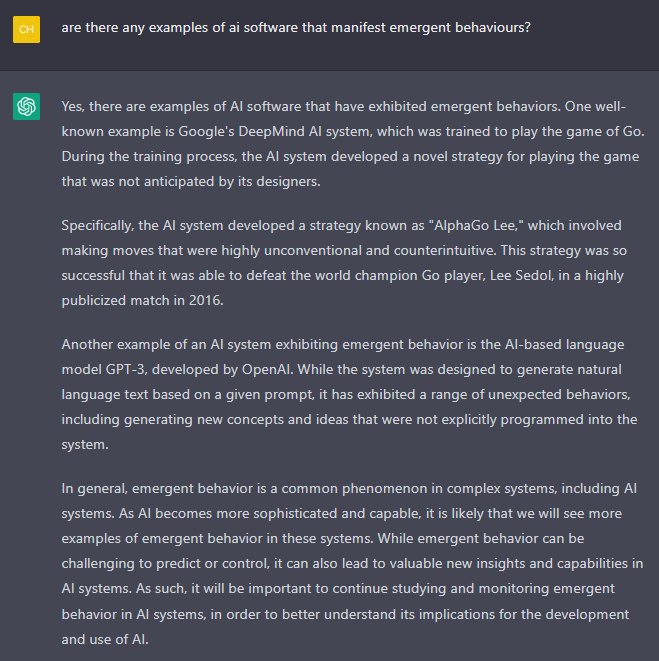

În continuare, interesul meu a mers spre Emergent Behaviours și am vrut să văd cam ce pot scoate de la el pe filonul asta. Nu am pretenția că acesta este un hack, dar practic GPT a recunoscut că chiar el a luat-o razna …

Surprins de sinceritatea bot-ului, am săpat mai departe. Știam de DeepMind și personal am fost impresioant nu de Go (pe care nu îl cunosc) ci de felul cum l-au învățat să joace StarCraft2 (la care am ajuns și eu până la Platină). Dacă Go are totuși un set de mutări finite (chiar dacă multe), clare, precise, universul opțiunilor din StarCraft2 este mult mai mare, sau cel puțin asta e percepția mea.

Despre Go, am auzit că unul dintre jucătorii de top s-a lăsat de Go deoarece a fost trist că IA deja bate omul. Go însemna creativitate și capacitate umană de a gândi creativ – faptul că un calculator poate depăși omul și la asta, i-a distrus motivația de a mai juca.

Cu privire la profeția din final, vă rog să recitiți – vom vedea mai departe de ce e posibil ca într-un an doi, pe măsură ce o nouă versiune a GPT (cel puțin – nu cunosc despre alte sisteme, cum ar fi Bingul cu care sunt la început) va fi introdusă care are un număr de parametrii cam de 10 ori mai mult ca cel actual, comportamentele emergente cu noul potențial, la care aș adauga și eventuala posibilitate ca datele să fie actualizate și poate-poate chiar să fie dezlegate unele feed-uri de date în timp real, vor face ca Breaking News-urile să fie de o cu totul altă natură decât cele din prezent.

Ca o mică paranteză, legată de întrebarea de ce nu are Chat GPT date recente. Mulți utilizatori s-au lovit de justificarea și atenționarea botului că nu e la curent cu evenimente decât până în septembrie 2021 (sau cam așa ceva), că după asta nu a mai fost antrenat. Dacă nu știm explicațiile autorilor (și eu nu le știu) de bun simț ar fi să credem că deoarece e nevoie ca să verifice cum răspunde botul la toate chestiunile senzitive (ce țin de noua ideologie woke, de plandemie și de Marele Reset), autorii s-au gândit să îi taie macaroana și doar să îl monitorizeze. Dacă i-ar permite să învețe live sau și mai nasol din interacțiunea cu userii, riscurile sunt masive. A învățat asta pe pielea lui Microsoft când lansase botul care răspundea pe Twitter și care învățând de la useri a ajuns extremist, republican și antisionist. O a doua explicație ar fi resursele – probabil datele necesită curare (nu bagi orice junk aiurea de pe internet în ditamai bijuterie de bot care vrei să educe boporul în viitor) și de asemenea, poate încă se lucrează la modulele de fact checking care să permită botului să învețe singur de unde să aleagă și cum să interpreteze datele cu care este antrenat.

Există deci două tipuri de date – unul pe care se face trainingul și botul cumva își dezvoltă sistemul de gândire și altul de unde își extrage informațiile și dă răspunsuri. Ideal ar fi ca măcar asta să fie live, pentru ca botul să poată citi singur știrile și deduce ce și cum. Eu sunt sigur că oricum ce vedem noi este o versiunea fără cohonesc, un castrat care se comportă cât de cât stabil și nu dă mult în bălării. Imaginați-vă însă ce se distrează cei care lucrează la bot pe date live … Acum recunosc că îl cred pe tipul de la Google care a ieșit în presă să avertizeze că botul google a luat-o razna. Mai e și incidentul cu botul Bing care vroia să fure codurile nucleare sau să creeze un virus mortal ….

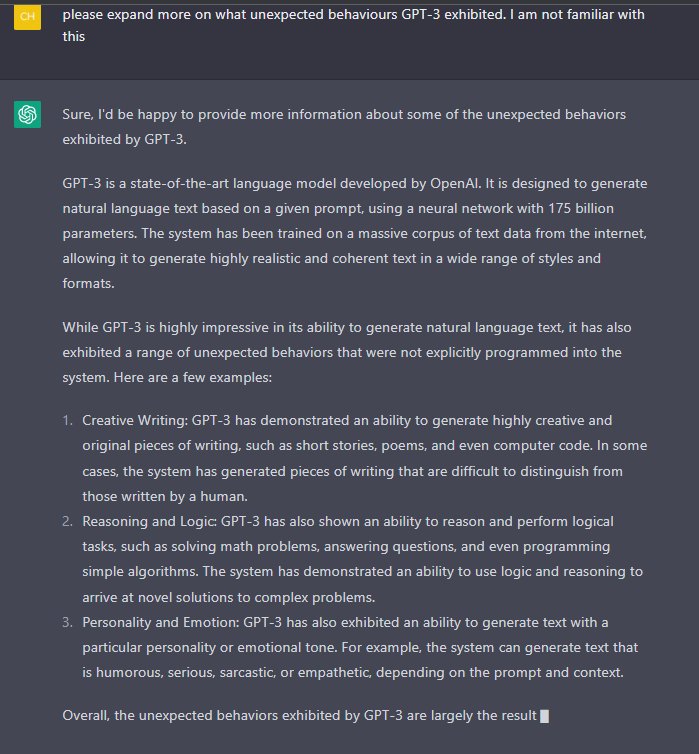

Întorcându-mă la discuția mea cu ChatGPT am fost curios despre aceste emergenție ale lui și văzându-l deschis, i-am cerut mai multe detalii.

Așadar, GPT-3 are 175 miliarde parametrii. GPT-4 va avea peste 1 trilion și va fi lansat la începutul acestui an (dacă l-or mai lansa sau îl bagă la naftalină de frică, cum face Google). Ideea cu parametrii este că cu cât sunt mai mulți cu atât comportamentul “emergent” “neașteptat” este mai variat și există posibilitatea ca botul să dea chix cu multe lucruri. Cu siguranță că totul e monitorizat, există anumite mecanisme interne de control (cum vom vedea) dar practic parametrii dau potențialul de variație, complexitate și elaborare al modului de a răspunde dar și a modului de a da răspunsuri. Nu este deloc exclus de exemplu, ca GPT-4 să înceapă să povestească totul despre plandemie cap coadă cum s-a întâmplat, caz în care mulți vor fi șocați.

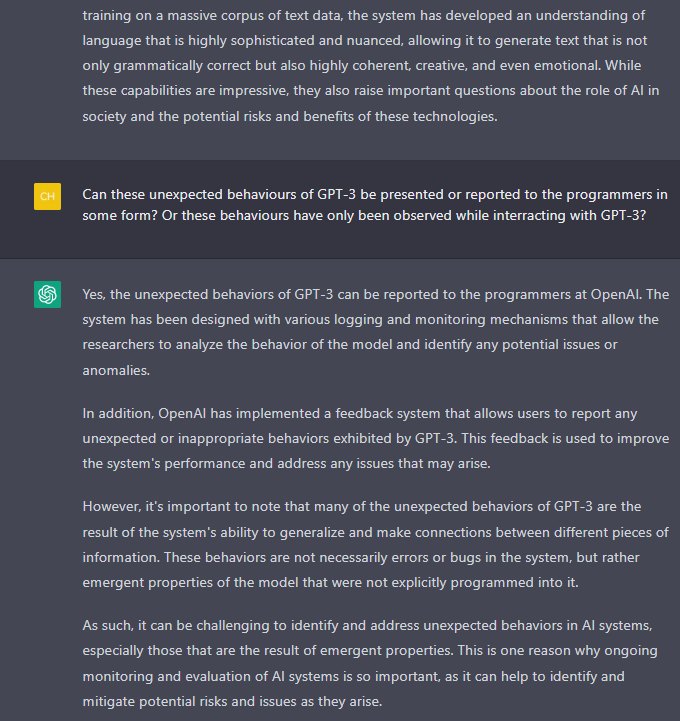

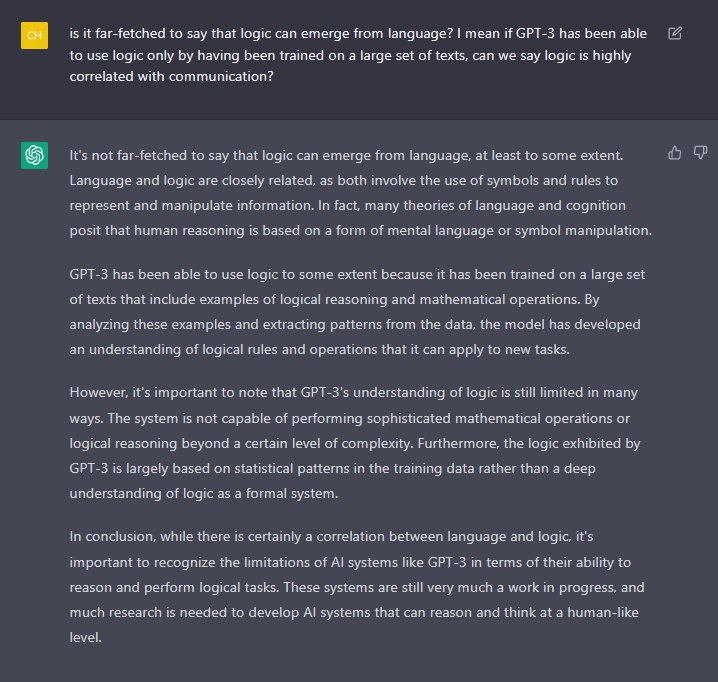

Din răspunsurile date de el mi s-a aprins iar beculețul la 2, cum adică a învățat logică din limbaj? Din puținele mele cunoștințe tehnice, un model de limbaj are ca principii fundamentale tokenizarea termenilor, a propozițiilor, a contextului etc. Apoi, pe baza învățării pe un set imens de date, botul practic caută rapid cele mai potrivite formule de a găsi un răspuns la un anume set de tokenuri (etichete). Face asta căutând cât mai rapid în memorie exemple similare. Cel mai banal exemplu ar fi 1+1=2. Un bot poate învăța asta și dacă este întrebat, poate deduce că tot timplu 1+1=2. Dacă altceva nu este învățat, nu va putea în veci să știe cât face 1+2 deoarece nu are nicio noțiune matematică, totul este efectiv căutare în memoria masivă de discuții anterioare a unor referiri la 1+1. Simplificarea mea probabil distruge complet realitatea, dar în esență ce vreu să zic este că “gândirea” botului se bazează pe imitație nu pe logică. Într-adevăr că dacă ai citit tratate întregi de logică, poți să ajungi să imiți și să redai unele răspunsuri corecte, fără a avea habar de semnificația simbolurilor cu care operezi sau doar având cunoștințe minime. Adică, un student la matematici superioare poate de exemplu memora formulele și rezolvarea unor probleme. Pe alocuri poate opera unele schimbări la soluția unei probleme (de exemplu poate schimba variabilele folosite) sau poate reformula unii termeni, sau poate face o paralelă și dacă primește o problemă similară, dacă știe o rezolvare, poate face o oarecare imitație a procesului în care se ajunge la soluție. Dar nu poate resolva ORICE problema din domeniul respectiv cum ar putea face un computer care ar înțelege conceptele și ar putea opera în logica (epistemiologia) acelui domeniu.

De aceea zice GPT că dezvoltarea logicii și rațiunii doar din analiza limbajului a fost ceva neașteptat. Personal cred că surpriza la specialiștii în domeniu ar fi de 50-50%, deoarece mulți sunt de părere că oricum limbajul este strict legat de rațiune, conține cumva esența logicii și este strict legat de raționament, ca să nu mai zic că mulți includ în discuție și conștiința. Nu vreau să bat câmpii prea mult, dar din ce știu încă este dilemă dacă poate exista rațiune în afara limbajului, în afara formalizării și formulării sub formă de limbaj a oricărei probleme. Din ce știu eu, încă nu s-a găsit răspuns la această întrebare.

Deci nu zic că am fost foarte mirat sau că aș fi mirat dacă un bot IA ar învăța logica din analizarea lingvistică a tuturor tratatelor despre logică care există. Am mers deci pe firul logicii și am venit cu un alt set de întrebări, dar cred că nu le-am mai salvat pe toate. Reiau de unde am salvările … cred că am sărit peste câteva întrebări legate de logică și cum a învățat GPT să opereze cu logica. În răspunsuri iar a venit discuția despre … deraieri (ca să le zic așa) de la un mod standard de deducție și gândire și am fost mai ales curios dacă botul se prinde de astfel de … incosistențe, cam cum era ecranul blue screen pe vremuri. Adică, mă gândesc eu, că dacă primește unele întrebări despre care deși le consideră corect formulate și clare, nu dă un răspuns care să aibă o rată mare de evaluarea a corectitudinii, are oare botul vreun mecanism de autoreglare sau măcar de notificare a programatorilor că este o problema? Vă reamintesc aici povestea cu Haiku. În cazul de față, deși discuția era despre logică, dilema mea e dacă în acel caz, botul s-a prins cumva totuși că exemplele nu erau corecte, chiar dacă mie mi le-a prezentat ca corecte sau măcar dacă din discuția cu mine se poate recalibra și poate învăța pe viitor. Mecanismul de feedback al userilor este într-adevăr ceva util, probabil extrem de puțin folosit dar care dat fiind volumul mare de utilizatori ai botului (peste 1 milion) cu siguranță ajută imens – e ca și cum ar exista practic mii de angajați din varii domenii care validează sau invalidează răspunsurile botului, permițând astfel inginerilor să vadă de ce sunt unele probleme și să îl repare.

Acum vine o întrebare despre care am tratat deja mai sus, legată de logică și limbaj. E posibil ca ordinea în discuție să nu fie musai aceasta și e posibil ca salvările mele (printscreen-urile) să fie puțin încurcate pe-aici.

Acum, un mic respiro. Țin să atrag atenția că ChatGPT este un tip de bot construit pe o anume arhitectură care are un domeniu de aplicare clar, anume înțelegerea limbajului uman. Acum 20-30 de ani, nivelul la care ne aflam era de recunoaștere a literelor de mână. Adică Inteligența artificială se ocupa cu recunoașterea caracterelor. Unul dintre corifeii IA de astăzi, Raymond Kurzweil este chiar inventatorul unui soft de recunoaștere a caracterelor pe baza inteligenței artificiale din anii 1970. În cazul ChatGPT, nu doar că recunoaște (într-un fel) întrebarea noastră și e capabil să își dea seama dacă are sens, dar poate să ne și răspundă, pe baza citirii unor texte de cantități inimaginabile (75TB zice el, probabil date arhivate procesate, deja formatate pentru el).

Alți boți însă au alte arhitecturi și urmăresc scopuri total diferite. De exemplu unele arhitecturi sunt mai potrivite pentru conducerea autonomă a vehicului. Și acele sisteme IA au nevoie de învățare, au particularitățile lor și pot dezvolta comportamente emergente neașteptate. Prin urmare, pot să existe și programe de inteligență artificială specializate în logică care să înțeleagă formalismul, să opereze cu simbolurile logice clasice, să poată analiza toate problemele de logică, toate teoremele și să fie pregătiți să rezolve problemele de logică de orice complexitate. Practic orice au putut face toți logicienii de când s-a inventat logica și tot ce există în toate cărțile. Nu mai zic că pot să și producă probleme de logică, cu diverse grade de dificultate sau poate să corecteze lucrarile studenților și să le dea note.

De aceea menționează chat GPT că nivelul de complexitate al problemelor de logică pe care îl poate rezolva este limitat, deoarece el a învățat logica trăgând cu urechea la ce au zis alții, nu fiind antrenat pentru asta. Idem cu componenta creativă, creativitatea nu se poate învăța. Dar în esență, când ai acces la o varietate de date imensă, simpla combinare a acestora în numite patternuri, care patternuri pot fi extrase tot din acel set de date, poate produce chestii noi sau cel puțin care par a fi noi. Dar așa cum creativitatea se manifestă în spațiul fizic, boții de IA, având date suficient de multe și observând patternuri din diverse domenii, pot pur și simplu asimila tot ce a creat omul și dezvolta o creativitate emergentă suficient de misterioasă pentru a pune sub semnul întrebarii raportul cu creativitatea umană.

Și chestiunile fierbinți abia au început să apară. Voi continua această discuție într-un articol viitor, prezentând întrebări legate de:

- patternuri statistice de învățare (și dacă Chat GPT poate învăța singur)

- lipsurile cognitive ale Chat GPT (chiar mi-a dat o listă)

- ontologia interacțiunilor umane și a experiențelor personale și o paralelă cu potențialul IA

- câteva vorbe despre creativitate

- câteva amănunte spicy despre măruntaiele interne ale Chat GPT

Ca rezumat în acest articol am abordat 7 din întrebările discuției și mai am 14 salvate cu care sper să continui și să analizez și restul discuției dacă o să văd că acest articol trezește interes la fel ca cele anterioare despre GPT.

Nu de alta, dar am în coadă și câte ceva despre Bing, deși experiența e puțin … gâtuită după deraierile recente. Bing are însă unele chestiuni specifice care îi conferă o cu totul altă personalitate și unele avantaje dar dacă ar fi să fac o comparație, deocamdată prefer GPT.